Když to zjednodušíme, současné velké jazykové modely (LLM) typu GPT, Llama, Claude nebo Mistral byly natrénovány na datech z internetu. Ke stahování na webu se „povalujících“ informací slouží takzvaný scraping, kdy počítačoví boti obchází internet a získávají vše potřebné.

Scrapují „všichni“ a různé sektory tuto metodu používají k různým věcem, e-shopy například pro hlídání a dorovnávání cen konkurence. Ne každý provozovatel webů ale chce data botům poskytovat. Téma ožilo právě s příchodem LLM. Zahraniční stránky často začaly boty od OpenAI a spol. blokovat. V Česku je takových webů zatím minimum. Až na stránky médií.

Pražská společnost Apify, která vyvíjí scrapovací nástroje a umožňuje uživatelům si připravit a provozovat vlastní scrapovací roboty, provedla analýzu tisícovky českých webů s největší návštěvností, stejný počet prověřila na Slovensku. Výsledek: zatímco v USA boty stahující data pro trénink umělé inteligence (LLM) blokuje třetina největších stránek, u nás jsou to pouhá tři procenta.

Nejčastěji přístup AI botům blokují tuzemská média. Z 90 analyzovaných bylo blokování nastaveno na téměř polovině z nich. Patří mezi ně ČTK, iDnes, Lidovky, Nova, Deník, Extra.cz, Metro a další.

Rozsah blokování se liší, což lze vyčíst z nahlédnutí do souborů robots.txt, kde se přístup botů k obsahu daných webů zakazuje. Například iDnes specificky omezuje robota GPTBot od OpenAI. TN.cz od Novy k tomu přidává anthropic-ai, ChatGPT-User a CCBot (nástroj Common Crawl používaný mimo jiné OpenAI). U jiných webů se objevují boti typu Google-Extended nebo Omgilibot.

Nejčastěji se u nás blokuje GPTBot, jeho zákaz byl zjištěn u 21 českých a 14 slovenských webech. Následují ClaudeBot (devět českých a 10 slovenských webů) a anthropic-ai (pět, respektive devět stránek).

Kromě médií v Česku boty pro AI často blokují pracovní portály jako Jobs.cz nebo Práce.cz. Podle průzkumu Apify jde o čtyři z 10 analyzovaných webů.

Vytěžování bez kompenzace

V robots.txt se také objevuje příkaz „User-agent: MachineLearning, Disallow: /“. Jeho začlenění už v loňském roce doporučilo Sdružení pro internetový rozvoj (SPIR), jehož členy mimo jiné jsou některé velké mediální domy. SPIR se zasazuje o standardizaci takzvaného opt-outu, kdy provozovatelé webů mohou vytěžování obsahu pro účely AI zamítnout.

„K vytěžování dat, která vytvořil člověk, autor, a jsou chráněna autorským právem, dochází zpravidla bez poskytování jakékoliv formy kompenzace,“ upozornilo sdružení.

Postoj médií ke scrapování obsahu je podobný tomu, co lze slýchat v zahraničí. Tvorba obsahu je finančně náročná, a pokud ho bot získá a LLM začlení do své znalostní báze, média zdarma vyprodukují data pro služby, které je potenciálně mohou výrazně ohrozit. LLM a na ně napojené služby totiž umí „přežvýkat“ a předložit informace bez toho, aby uživatel musel jít na stránku, z níž AI čerpá. Média tak přichází o návštěvnost a příjmy z reklamy.

„Blokování má několik důvodů. Příprava článků nás stojí nemalé finanční prostředky a také samozřejmě čas, je to naše autorská práce. Dalším důvodem je například to, že některé zdroje, které využíváme, si nepřejí, aby pak byly jejich výstupy propojovány s umělou inteligencí. Pak jde třeba i o SEO,“ popsal Lupě Vladimír Rosol, šéfredaktor zpravodajství a webu TN.cz, který spadá pod TV Nova.

Co na to zákony

Jenže zákaz botů v robots.txt nemá oporu v zákonech, takže ho lze obcházet. Nejenom v mediální branži se nyní sleduje spor mezi tandemem Microsoft plus OpenAI a novinami New York Times. Vlivné americké médium obě technologické firmy zažalovalo kvůli tomu, že pro trénink chatbotů byly bez svolení použity miliony článků Timesů.

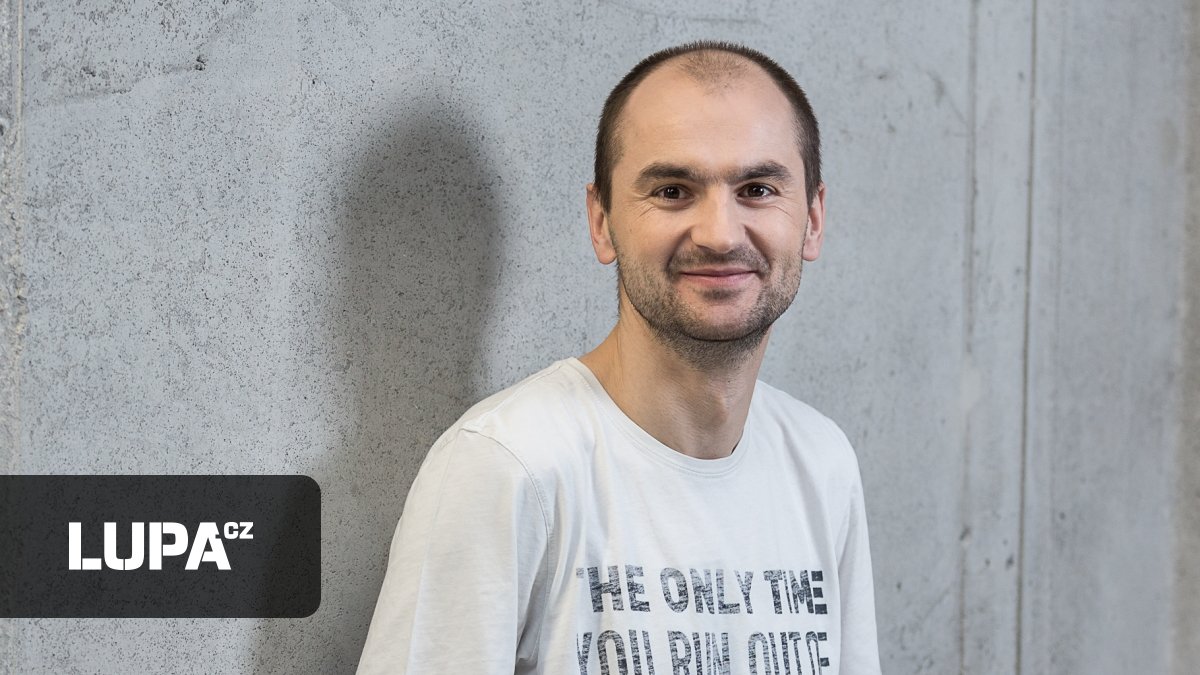

Spor potenciálně může dospět k tomu, že scrapování obsahu spadá podle amerických zákonů pod tzv. fair use, takže půjde dále scrapovat veřejně dostupný obsah a soubor robots.txt ignorovat. Pokud ale soudy dojdou k tomu, že trénink AI pod fair use nespadá, může se jednat o porušení podmínek. „Buď to vyřeší soudní spor a vznikne precedent, nebo se na to vrhnou zákonodárci. Byl jsem teď v USA a politici tam toto téma hodně řeší, nějaká legislativa zřejmě vznikne,“ popsal Lupě Jan Čurn, ředitel Apify.

Stále více zpravodajských webů přístup k obsahu schovává za paywally, bez registrace a předplatného se tedy k němu nejde dostat. AI boti se teoreticky za paywall mohou „vlámat“ skrze založení účtu, pravděpodobně by to ale znamenalo porušení podmínek. „Ve scrapingu obecně platí, že jakmile se musíte přihlásit, je nutné akceptovat podmínky služby a tam je použití pro boty zakázáno,“ podotýká Čurn.

Téma webharvestingu se rovněž aktuálně debatuje v projednávané trojnovele zákonů (knihovní, tiskový a o neperiodických publikacích). SPIR se dále zapojil do konzultace Evropské komise k tvorbě kodexů pro všestrannou AI.

Tajemný Seznam

To, že je dolování webových dat pro účely trénování AI citlivá věc, naznačuje i postoj Seznamu. Největší česká internetová firma pracuje na vlastním jazykovém modelu a úpravách velkých zahraničních modelů pro účely češtiny. Seznam kvůli tomu nakoupil nemalé množství karet od Nvidie.

Lupa se Seznamu zeptala, zda firma pro účely trénování LLM používá scraping dat z českého internetu a zda je získává i ze zpravodajských webů. Mluvčí Seznamu Aneta Kapuciánová vzkázala, že firma tentokrát na dotazy reagovat nechce. O tom, zda Seznam něco stahuje, se tedy dá jen spekulovat. Firma má ovšem i díky serverům typu Novinky nebo Seznam Zprávy dostatek vlastního obsahu.

Další otázkou je, jak by se k tématu měla postavit veřejnoprávní média. Ta od občanů vybírají koncesionářské poplatky a obsah poskytují „zdarma“, tudíž se nabízí, že by měl být dostupný i pro trénink umělé inteligence.

Český rozhlas pro Lupu uvedl, že prozatím nezaujal konečné stanovisko, stát by se tak mělo v dohledné době. „Vyhodnocujeme v zásadě tři pro nás důležité aspekty – jednak naše postavení média veřejné služby, dále technické parametry takového blokování, aby bylo účinné, a pak také postup ostatních médií veřejné služby v rámci Evropské vysílací unie,“ shrnul ředitel komunikace Rozhlasu Jiří Hošna.

Česká televize žádná opatření proti AI botům na svých webech nemá. „Téma však vedeme v patrnosti v rámci probíhající interní diskuse o mantinelech při používání AI v rámci ČT. Prozatím tedy zvažujeme, jaké kroky by byly nejvhodnější v kontextu našeho poslání jako veřejnoprávní instituce,“ sdělila neurčitě mluvčí televize Vendula Krejčová.

Lokální kulturní specifika

Apify má na scrapingu postavený byznys, proto hájí volný přístup k datům. Firma ostatně pomáhala nejmenovanému zákazníkovi z Blízkého východu scrapovat miliardy stránek na trénování lokálního AI modelu v arabštině.

Se zakazováním vytěžování dat souvisí i další otázky: třeba lokalizace. Jak upozornil technologický ředitel Amazonu Werner Vogels, jednotlivé státy by měly mít vlastní lokální LLM modely, které budou reflektovat specifika dané země. Pohled USA na určité téma se může zcela lišit od pohledu Česka či Kosova. „Současné jazykové modely jsou velmi anglo- a americkocentrické. Nejde ani tak o jazyk, jde hlavně o kulturu, která se do těchto modelů promítá,“ popsal Vogels.

Čurn z Apify s tímto pohledem souhlasí. „Chápu potřebu zamykat obsah, ale českým modelům to uškodí. Když budou existovat kvalitnější modely v angličtině, lidé budou používat je. Je nutné mít lokální modely kvůli udržení kultury, pohledu na věc a něčemu jako národnímu obrození,“ uvedl Čurn.

Teoreticky může nastat situace, že trh s modely opět zcela ovládnou američtí giganti a malé trhy jako Česko budou odkázány na to, až se na ně v případě jazykových mutací dostane řada. Jak vidíme na současných produktech nadnárodních technologických šampionů, Česko je vždy až v pozdějších vlnách, takže na novinky musí čekat. Stejně tak z Česka utíkají tržby, data a tak dále.

Postoj mediálních domů je ale plně pochopitelný a zřejmě bude muset dojít k dohodám o licencování obsahu pro trénovací účely. V USA už začaly vznikat startupy, které se starají o zprostředkování takových dohod.

Bude dostatek dat?

Pokud LLM modely nebudou mít k dispozici kvalitní data, promítne se to i do jejich schopností. Google například uzavřel licenční smlouvu s Redditem a čerpá materiál z jeho nekonečných fór. Tamní obsah ale není vždy kvalitní či fakticky správný, takže není zase tolik užitečný. Média servírují obsah, který se sice může kvalitou dost lišit, ale často je alespoň nějak prověřovaný. Pro trénování LLM se tak jedná o zajímavý zdroj. Pokud tedy chceme dobrou AI, měla by se učit na co největším vzorku veřejně dostupných dat.

„Za pár let nám dojdou kvalitní trénovací data. Tempo, kdy se generuje nový dobrý obsah, nedokáže pokrýt hlad modelů. Aby GPT-6 bylo výrazně lepší, bude potřebovat mnohem více informací,“ upozorňuje Čurn.

Proto se už nějakou dobu řeší takzvaná syntetická data, tedy informace generované specificky pro trénování AI. Čurn ale v tomto případě mluví o takzvaném datovém incestu, protože může dojít k divergenci. Tématu se věnuje ve své disertační práci.

Firmy jako OpenAI se snaží dostat také k datům, která nejsou veřejně dostupná. Jde například o různé firemní a další databáze – třeba profesionální analytické podniky mají mnoho užitečného materiálu. Data se mezi jejich sběrači a nakupujícími obchodují dlouhodobě, zde by to neměla být výjimka.

„Firmy jako Scale AI mají nejlepší lidi z oboru a používají velmi kvalitní datasety na trénování, a ne pouze všeobecně dostupné informace na internetu. Možná jsme se ale dostali na limity toho, jaké lidstvo dokáže vygenerovat objemy dat, aby to bylo AI k něčemu užitečné,“ doplnil v rozhovoru Hubert Palán, výkonný ředitel českého jednorožce Productboard.