Apple oznámil několik chystaných opatření, které mají podle firmy omezit šíření dětské pornografie a dalších materiálů týkajících se zneužívání dětí (Child Sexual Abuse Material, CSAM). O plánu informoval nejdřív deník Financial Times a Apple jej poté potvrdil.

Nová opatření mají přijít v aktualizacích systémů iOS 15, iPadOS 15, watchOS 8 a macOS Monterey a zatím se mají týkat pouze uživatelů v USA.

Prvním opatřením má být to, že aplikace Messages bude kontrolovat, zda dětem někdo neposlal (nebo samy neposílají) obrázky s explicitně sexuálním obsahem. K detekci má Apple používat technologii strojového učení a má k ní docházet přímo v zařízení. Pokud systém sexuální fotky odhalí, snímky rozmaže a upozorní dítě na jeho nevhodnost. Novinka se má týkat Apple účtů, které jsou nastaveny jako rodinné.

Druhé opatření se týká vyhledávání a hlasové asistentky Siri. Nově mají reagovat na to, když bude uživatel vyhledávat informace související se sexuálním zneužíváním dětí a mají ho v takovém případě upozornit na nevhodnost dotazu a dát mu informace o tom, jak podobný obsah nahlásit.

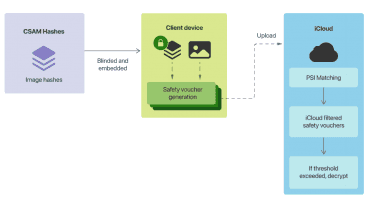

Největší kontroverze vzbudilo třetí opatření, které se má týkat systémů iOS a iPadOS, respektive jejich podzimní aktualizace. Systémy Applu v nich budou prověřovat fotky uložené v cloudovém úložišti iCloud. Budou je porovnávat s hashi známých snímků s dětským pornem z databáze organizace National Center for Missing and Exploited Children (NCMEC) a dalších organizací. Detekce má probíhat opět přímo v zařízeních, která si budou hashů databázi ukládat.

Pokud automatický systém nahlásí shodu s nějakým snímkem v iCloudu uživatele, Apple bude provádět ještě manuální kontrolu. Když se nevhodný obsah potvrdí, Apple účet zablokuje a předá informaci NCMEC. Uživatel má mít možnost se proti zablokování odvolat.

Technické detaily celého procesu Apple zveřejnil v dvanáctistránkovém shrnutí (PDF v angličtině).